들어가며

대형 언어 모델(LLM)은 클라우드 환경에서 주로 사용되지만, 개인정보 보호 및 비용 절감을 위해 로컬 환경에서 실행하는 방법도 점점 주목받고 있습니다.

이번 글에서는 Chatbox를 활용하여 로컬에 설치된 LLM을 실행하고 활용하는 방법을 상세히 설명합니다. 특히, Ollama와 연계하여 Chatbox에서 LLM과 인터페이스하는 과정을 다룹니다.

1. Chatbox란?

Chatbox는 로컬 또는 클라우드 환경에서 실행되는 LLM과의 대화를 쉽게 할 수 있도록 도와주는 웹 기반 인터페이스입니다. Chatbox를 활용하면 사용자는 복잡한 명령어 없이 간편하게 AI 모델과 상호작용할 수 있으며, 다양한 기능을 사용할 수 있습니다.

1.1 Chatbox의 주요 장점

- 직관적인 웹 인터페이스: 별도의 프로그램 설치 없이 브라우저에서 AI 모델과 채팅 가능

- 개인정보 보호: 클라우드 기반 API를 사용하지 않고 로컬에서 실행 가능하여 데이터 유출 방지

- 다양한 모델 지원: Ollama, GPT 계열 모델, DeepSeek 등 여러 LLM과 연동 가능

- 유연한 설정: 사용자 맞춤형 프롬프트 및 API 경로 설정 지원

Chatbox는 이러한 장점을 통해 로컬 AI 모델을 보다 손쉽게 활용할 수 있도록 지원합니다.

2. Chatbox 설치 및 설정

Chatbox를 사용하려면 먼저 공식 웹사이트에서 다운로드해야 합니다.

2.1 Chatbox 다운로드 및 설치

- Chatbox 공식 웹사이트에 접속합니다: Chatbox 다운로드

- 운영체제에 맞는 설치 파일을 다운로드합니다.

- 다운로드한 파일을 실행하고 설치를 진행합니다.

- 설치가 완료되면 Chatbox를 실행합니다.

2.2 API 방식 선택

- Chatbox AI를 실행하면 처음에 "AI 모델 공급자를 선택하고 구성하세요."라는 안내 창이 나타납니다.

- 여기에서 로컬 AI 모델을 사용하려면 "내 자체 API 키 / 로컬 모델 사용" 버튼을 선택하세요.

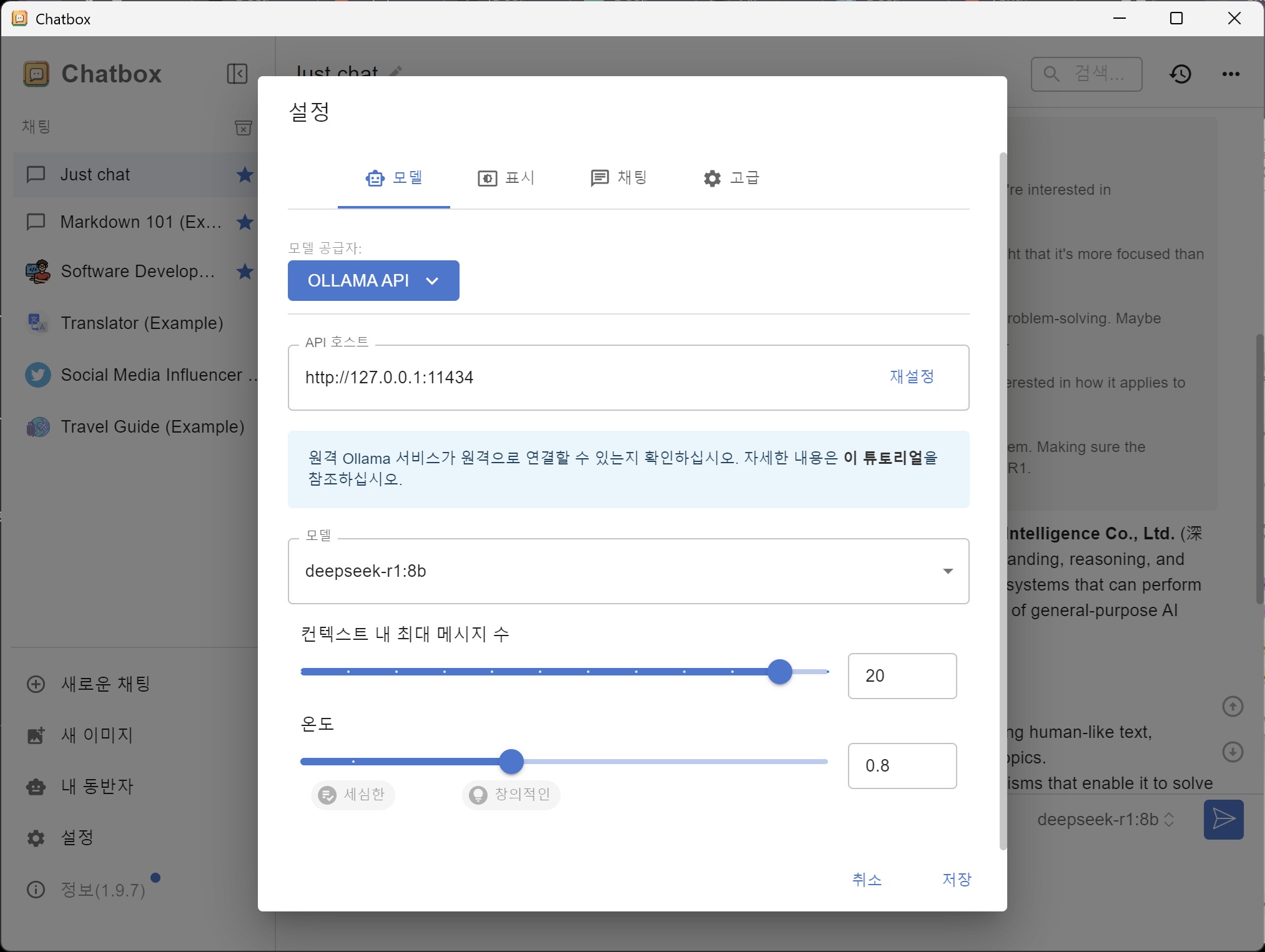

- 다음 화면에서 Ollama API를 선택합니다.

2.3 Ollama의 로컬 모델 설정

- '모델' select box에서 이전에 로컬 환경에 설치해둔 deepseek-r1 모델을 선택합니다.

2.4 추가 설정 변경

- "컨텍스트 내 최대 메시지 수" 및 "온도(Temperature)" 등의 매개변수도 손쉽게 조정할 수 있습니다.

- 온도(Temperature): 값이 높을수록 창의적이고 다양한 답변을 제공함.

3. Ollama의 로컬 모델 실행 및 테스트

Chatbox의 텍스트 입력 창에 Describe deepseek-r1을 입력해보면 모델이 Thinking 과정(추론 단계)을 거쳐 답변을 생성하는 것을 확인할 수 있습니다.

4. 마무리

이 글에서는 Chatbox를 활용하여 로컬에서 실행 중인 LLM과 상호작용하는 방법을 소개했습니다. Ollama와 연계하여 로컬 환경에서 LLM을 실행하고 Chatbox를 통해 보다 직관적으로 활용하는 방법을 설명했습니다.

이제 손쉽게 로컬에서 AI 모델을 실행하고 활용할 수 있습니다. 추가적인 기능이 필요하면 설정을 조정하거나 다른 LLM 모델을 사용할 수도 있습니다.

더 궁금한 점이 있다면 댓글 남겨주세요!