반응형

개요

DeepSeek R-1은 중국 AI 기업 DeepSeek이 개발한 오픈소스 AI 언어 모델입니다. OpenAI의 모델과 비교될 정도로 뛰어난 성능을 제공하며, 특히 로컬에서 실행할 수 있다는 점이 큰 장점입니다. 이 글에서는 Ollama를 활용하여 DeepSeek R-1을 로컬 환경에서 실행하는 방법을 설명합니다.

DeepSeek R-1 로컬 설치방법

- DeepSeek R-1을 로컬에 설치하려면 Ollama 도구를 사용하면 됩니다.

- Ollama는 macOS, Linux, Windows 환경에서 대형 언어 모델을 쉽게 실행할 수 있도록 설계된 무료 오픈소스 프로젝트입니다.

1. Ollama 설치

Ollama 다운로드 및 설치

- Ollama 공식 웹사이트에 접속합니다.

- 사용 중인 운영체제에 맞는 설치 파일을 다운로드합니다.

- 다운로드한 파일을 실행하여 Ollama를 설치합니다.

설치 확인 방법

설치 완료 후, 터미널(또는 명령 프롬프트)에서 아래 명령어를 실행하여 설치 상태를 확인합니다.

더보기

※ 명령 프롬프트(cmd) 열기

- Windows 사용자의 경우 Win + R을 누른 후 cmd 입력 후 엔터를 누르세요.

- Mac/Linux 사용자는 터미널을 엽니다.

ollama -v

- 버전 정보가 정상적으로 표시되면 설치가 완료된 것입니다.

2. DeepSeek R-1 모델 설치 및 실행

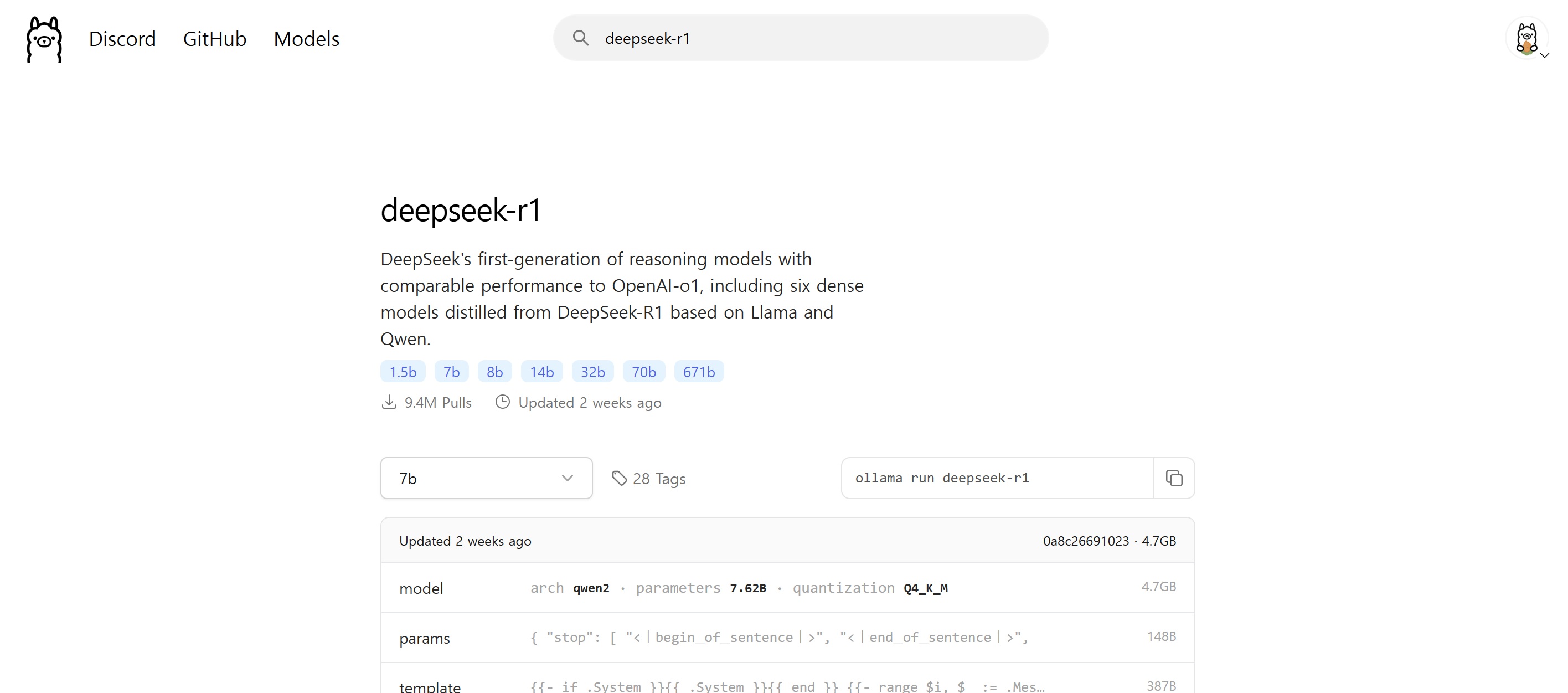

- Ollama 사이트에서 DeepSeek R-1 모델을 검색하시면 모델의 파라미터별로 다운로드 명령어를 확인하실 수 있습니다.

- 가벼운 모델을 설치해보기 위해 8b 모델을 선택하겠습니다.

3. CMD에서 Ollama 실행하기

- DeepSeek R-1 모델 다운로드 및 실행

- 명령 프롬프트에서 아래 명령어를 입력하세요.

ollama run deepseek-r1:8b- 실행하면 자동으로 모델이 다운로드됩니다.

- 다운로드가 완료되면 로컬 환경에서 모델이 실행됩니다.

- 8b는 8B(80억) 파라미터 버전이며, VRAM 8GB 이상의 GPU가 필요합니다.

2. 정상적으로 실행되었는지 확인

4. 모델에 질문하기

- 이제부터 Ollama 환경에서 DeepSeek R-1을 자유롭게 사용할 수 있습니다.

> Prompt: What is DeepSeek R-1?

<< Response: DeepSeek-R-1 is an AI assistant developed by the Chinese company DeepSeek ...DeepSeek R-1 성능 분석

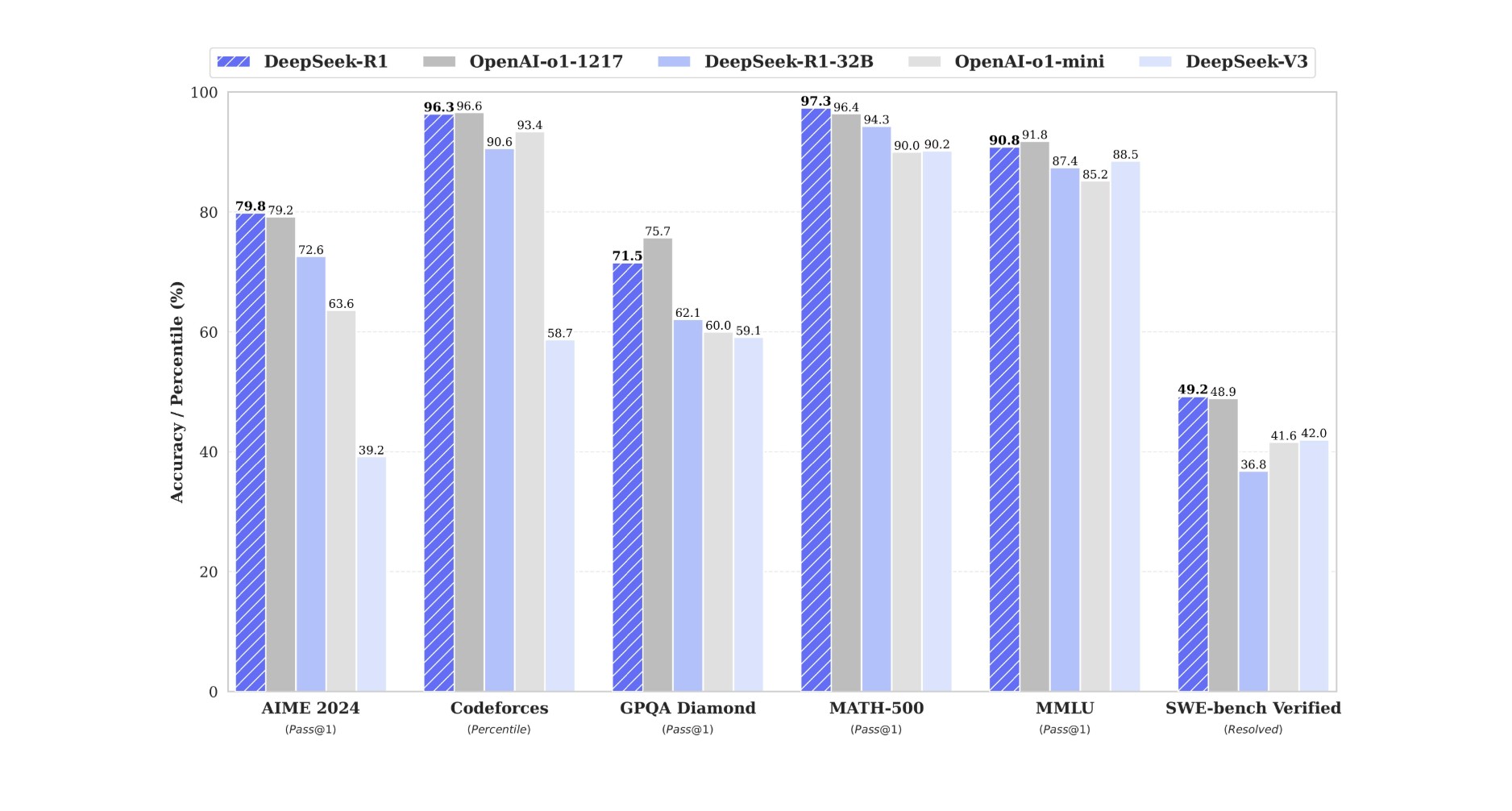

- Ollama에서 DeepSeek R-1을 검색하면 모델 성능과 관련된 다양한 벤치마크 정보를 확인할 수 있습니다.

- 해당 벤치마크는 DeepSeek R-1이 어떤 분야에서 강점을 보이는지를 평가하는 지표로 활용됩니다.

주요 벤치마크 설명

| AIME 2024 | 수학 문제 풀이 |

| Codeforces | 알고리즘 문제 풀이 |

| GPQA Diamond | 일반 지식 질의응답 |

| MATH-500 | 고급 수학 문제 해결 |

| MMLU | 다양한 과목에 대한 지식 테스트 |

| SWE-bench | 소프트웨어 엔지니어링 문제 해결 |

DeepSeek R-1의 VRAM 요구 사항

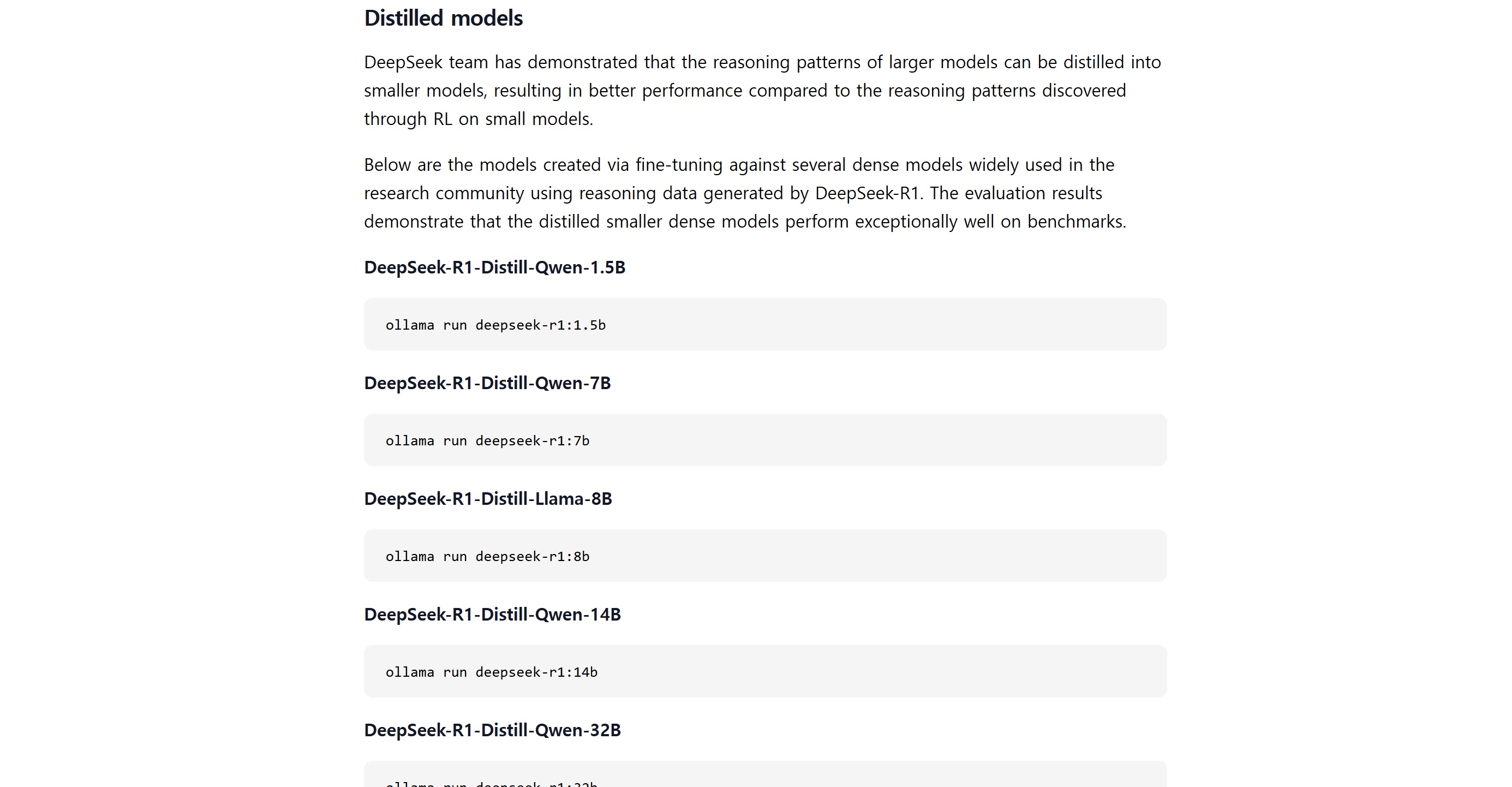

- DeepSeek-R1의 VRAM 요구량은 모델 크기와 양자화(quantization) 적용 여부에 따라 달라집니다.

| 모델 변형 | 파라미터 수 (십억) | VRAM 요구량 (GB) | 권장 GPU |

| DeepSeek-R1 | 671 | 약 1,342 | NVIDIA A100 80GB ×16 |

| DeepSeek-R1-Distill-Qwen-1.5B | 15 | 약 0.7 | NVIDIA RTX 3060 12GB 이상 |

| DeepSeek-R1-Distill-Qwen-7B | 70 | 약 3.3 | NVIDIA RTX 3070 8GB 이상 |

| DeepSeek-R1-Distill-Llama-8B | 80 | 약 3.7 | NVIDIA RTX 3070 8GB 이상 |

| DeepSeek-R1-Distill-Qwen-14B | 140 | 약 6.5 | NVIDIA RTX 3080 10GB 이상 |

| DeepSeek-R1-Distill-Qwen-32B | 320 | 약 14.9 | NVIDIA RTX 4090 24GB |

| DeepSeek-R1-Distill-Llama-70B | 700 | 약 32.7 | NVIDIA RTX 4090 24GB ×2 |

- VRAM 사용량은 설정에 따라 달라질 수 있습니다.

- 전체 모델은 단일 GPU로 실행하기 어려우며, 다중 GPU 구성이 필요합니다.

- 디스틸된(distilled) 모델은 상대적으로 낮은 사양에서도 실행이 가능합니다.

마무리

DeepSeek R-1은 수학, 코딩 및 일반 지식 테스트에서 OpenAI의 모델과 비교해도 높은 성능을 제공합니다. Ollama를 통해 쉽게 다운로드하고 실행할 수 있으며, 로컬에서 사용할 경우 개인정보 보호, 오프라인 사용, 비용 절감, 유연한 활용 등의 장점을 누릴 수 있습니다.

명령 프롬프트 사용이 익숙하지 않다면, Chatbox AI를 활용하여 DeepSeek R-1을 웹 인터페이스에서 더욱 편리하게 이용할 수 있습니다. 아래 링크를 참고하시기 바랍니다.

Chatbox를 활용한 로컬 LLM 실행 가이드

추가 질문이 있거나 도움이 필요하시면 언제든지 댓글남겨주세요!

감사합니다.

반응형